Thông báo của AMD thể hiện thách thức lớn nhất đối với Nvidia, hiện đang thống trị thị trường chip AI với hơn 80% thị phần, theo các nhà phân tích.

GPU là những con chip được các công ty như OpenAI sử dụng để xây dựng các chương trình AI tiên tiến như ChatGPT.

Nếu chip AI của AMD, được gọi là "máy gia tốc", được các nhà phát triển và nhà sản xuất máy chủ chấp nhận để thay thế cho các sản phẩm của Nvidia, thì đó có thể là một thị trường lớn chưa được khai thác cho nhà sản xuất chip, vốn nổi tiếng với bộ xử lý máy tính truyền thống.

Giám đốc điều hành AMD Lisa Su nói với các nhà đầu tư và nhà phân tích ở San Francisco vào 13/6 rằng AI là "cơ hội tăng trưởng dài hạn lớn nhất và chiến lược nhất" của công ty.

"Chúng tôi nghĩ về thị trường máy gia tốc AI của trung tâm dữ liệu sẽ tăng từ khoảng 30 tỷ USD trong năm nay, với tốc độ tăng trưởng gộp hàng năm trên 50%, lên hơn 150 tỷ USD vào năm 2027", bà Su nói.

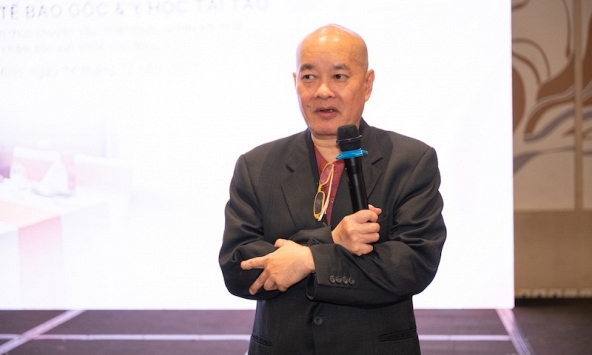

Bà Lisa Su cầm trên tay một con chip ADM Instinct M1300 khi bà có bài phát biểu quan trọng tại CES 2023 ở The Venetian Las Vegas vào ngày 4/1/2023 ở Las Vegas, Nevada. Ảnh: Getty

Mặc dù AMD không tiết lộ giá, nhưng động thái này có thể gây áp lực về giá đối với GPU của Nvidia, chẳng hạn như H100, có thể có giá từ 30.000 USD trở lên. Giá GPU thấp hơn có thể giúp giảm chi phí cao cho việc phục vụ các ứng dụng AI tổng quát .

Chip AI là một trong những điểm sáng trong ngành công nghiệp bán dẫn, trong khi doanh số PC, yếu tố thúc đẩy doanh số bán bộ xử lý bán dẫn truyền thống, sụt giảm.

Tháng trước, Giám đốc điều hành AMD Lisa Su cho biết trong một cuộc gọi thu nhập rằng mặc dù MI300X sẽ có sẵn để lấy mẫu vào mùa thu này, nhưng nó sẽ bắt đầu được vận chuyển với số lượng lớn hơn vào năm tới. Su đã chia sẻ thêm chi tiết về con chip trong bài thuyết trình của cô ấy vào ngày 13/6.

"Tôi yêu con chip này", bà Su cho hay.

AMD cho biết chip MI300X mới và kiến trúc CDNA của nó được thiết kế cho các mô hình ngôn ngữ lớn và các mô hình AI tiên tiến khác.

Theo bà Su, "trọng tâm của vấn đề này là GPU. GPU đang cho phép tạo ra AI".

MI300X có thể sử dụng bộ nhớ lên tới 192GB, có nghĩa là nó có thể phù hợp với các mô hình AI thậm chí còn lớn hơn so với các chip khác. Chẳng hạn, đối thủ H100 của Nvidia chỉ hỗ trợ bộ nhớ 120GB.

Các mô hình ngôn ngữ lớn cho các ứng dụng AI tổng quát sử dụng nhiều bộ nhớ vì chúng chạy số lượng phép tính ngày càng tăng. AMD đã demo MI300x chạy mô hình 40 tỷ tham số có tên là Falcon. Mô hình GPT-3 của OpenAI có 175 tỷ tham số.

"Kích thước mô hình ngày càng lớn hơn nhiều và bạn thực sự cần nhiều GPU để chạy các mô hình ngôn ngữ lớn mới nhất", Su nói, lưu ý rằng với bộ nhớ bổ sung trên chip AMD, các nhà phát triển sẽ không cần nhiều GPU như vậy.

AMD cũng cho biết họ sẽ cung cấp Kiến trúc Vô cực kết hợp tám bộ gia tốc M1300X của họ trong một hệ thống. Nvidia và Google đã phát triển các hệ thống tương tự kết hợp tám GPU trở lên trong một hộp duy nhất cho các ứng dụng AI.

Một lý do khiến các nhà phát triển AI ưa thích chip Nvidia trước đây là vì nó có gói phần mềm được phát triển tốt có tên CUDA cho phép họ truy cập các tính năng phần cứng cốt lõi của chip.

AMD cho biết hôm 13/6 rằng họ có phần mềm riêng cho chip AI mà họ gọi là ROCm.

Chủ tịch AMD Victor Peng cho biết: "Hiện tại, trong khi đây là một hành trình, chúng tôi đã đạt được tiến bộ thực sự lớn trong việc xây dựng một ngăn xếp phần mềm mạnh mẽ hoạt động với hệ sinh thái mở gồm các mô hình, thư viện, khung và công cụ".

Cùng chuyên mục

Chấm dứt hoạt động Chi nhánh Trung tâm Tâm lý Giáo dục Ngọc Bích

Longevity Medical tổ chức sự kiện gặp gỡ PGS.TS.BS Phan Toàn Thắng: Lan tỏa giá trị y học tái tạo vì sức khỏe bền vững

Thanh tra ‘gõ cửa’ điểm mặt loạt vi phạm, PNJ nói gì?

Có nên mua dự án Narra Residences tại khu đô thị Thủ Thiêm?

Tăng sức mua cho thị trường nội địa sẽ giúp Việt Nam ứng phó thách thức thuế quan?

Urenco 11 - Tiên phong trong hoạt động xử lý môi trường